La qualité des données se définit par l’adéquation des informations aux besoins de leurs utilisateurs. Longtemps perçue comme une préoccupation purement technique, confinée aux départements informatiques, sa gestion est aujourd’hui reconnue comme un impératif stratégique majeur pour toute organisation moderne. La capacité à prendre des décisions éclairées, à optimiser les opérations et à innover dépend directement de la fiabilité du capital informationnel. Bien plus qu’un simple enjeu de conformité technique, la maîtrise de la qualité distingue les entreprises qui subissent la complexité de celles qui l’exploitent pour innover.

1 – Les enjeux et le coût de la non-qualité : une dette technique et stratégique

Cette non-qualité ne doit pas être vue comme simple inconvénient opérationnel. Elle représente une dette qui génère des coûts directs, des pertes d’opportunités et des risques stratégiques majeurs. L’ampleur du problème est considérable : selon une analyse de Gartner, le coût moyen de la mauvaise qualité des données pour une organisation s’élève à 11 millions d’euros par an. Cette évaluation souligne l’urgence de traiter ce sujet non pas comme un projet informatique, mais comme un enjeu de performance pour l’ensemble de l’entreprise.

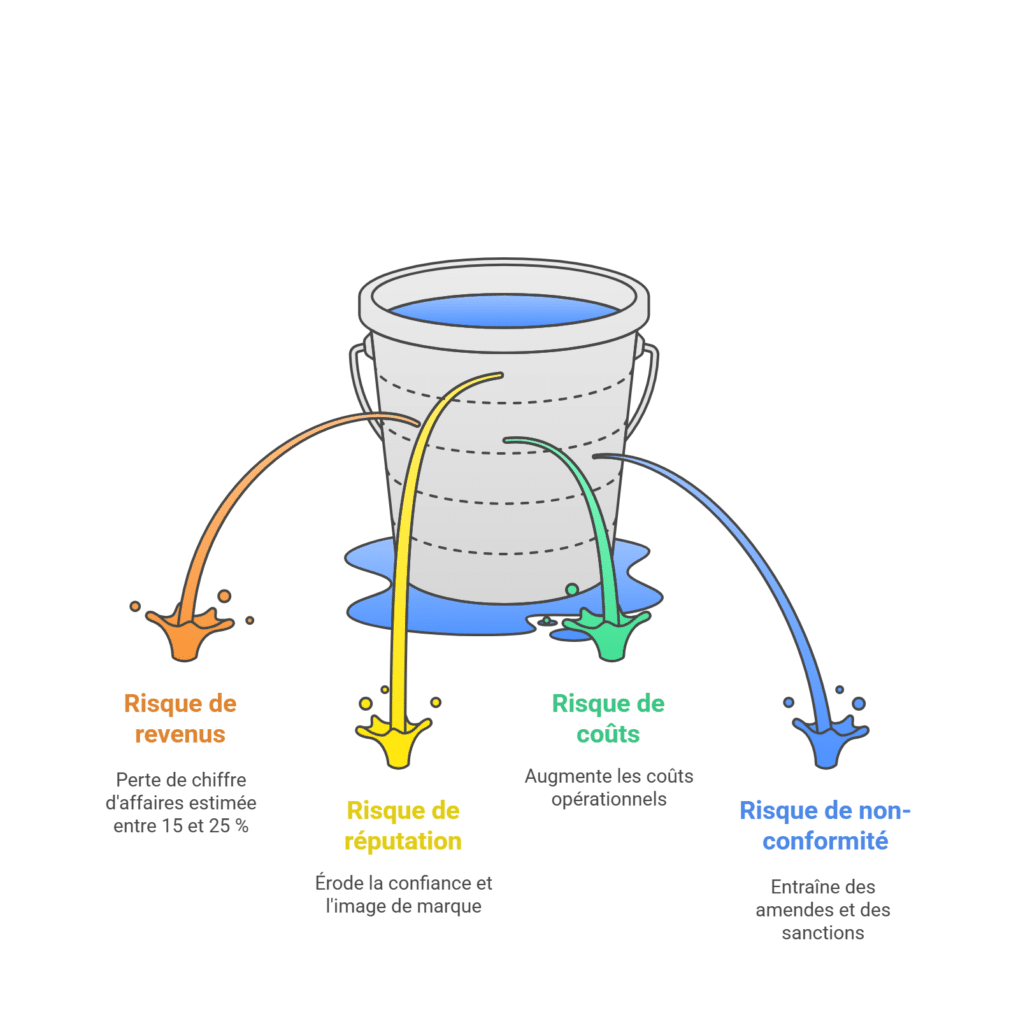

La non-qualité des données expose l’organisation à quatre types de risques majeurs qui peuvent directement affecter ses résultats et sa pérennité :

- Risque de revenus. Une mauvaise qualité des données peut entraîner une perte de chiffre d’affaires estimée entre 15 et 25 %. Cela peut se matérialiser par des erreurs de livraison, des campagnes marketing inefficaces ou des décisions stratégiques basées sur des prévisions erronées.

- Risque de réputation. Les erreurs visibles par les clients ou les partenaires (comme des erreurs de facturation ou de communication) nuisent à l’image de marque, érodent la confiance et peuvent rapidement se propager et avoir des répercussions durables.

- Risque de coûts. Ce risque correspond à l’augmentation des coûts opérationnels due à la non-qualité. Il inclut les ressources humaines mobilisées pour vérifier et retraiter manuellement les données, les coûts liés au rappel de produits défectueux, ou encore le stockage inutile de données obsolètes.

- Risque de non-conformité réglementaire. Le non-respect des réglementations (comme le nLPD/RGPD, Bâle II ou Solvabilité II) en raison de données inexactes ou incomplètes peut entraîner de lourdes amendes, des sanctions administratives, voire l’arrêt de certaines activités.

Face à des coûts et des risques d’une telle ampleur, une approche réactive n’est pas seulement inefficace, elle est stratégiquement intenable. Elle condamne l’organisation à un cycle perpétuel de corrections coûteuses et de perte d’opportunités. La seule réponse viable est de passer d’une posture défensive à une maîtrise offensive de l’actif informationnel, via une stratégie correctement formalisée et planifiée.

2 – L’importance de l’identification des parties prenantes.

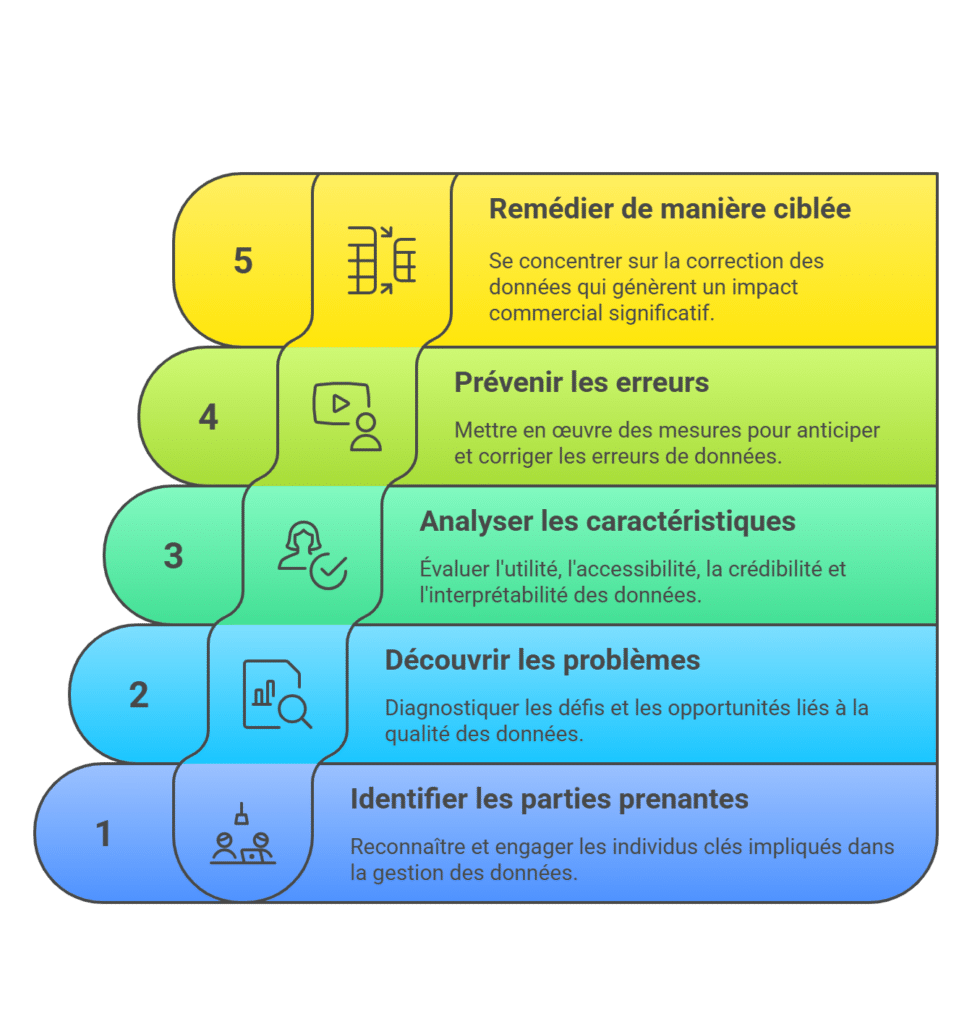

Avant même de commencer à élaborer la stratégie, une première étape est indispensable : identifier toutes les parties prenantes. Il s’agit de toute personne qui collecte, gère ou utilise les données pour prendre des décisions. Pour y parvenir, l’organisation peut doit de poser les questions suivantes :

- Qui a un intérêt direct dans la performance du système et la qualité des données qu’il produit ?

- Qui est directement impacté par la non-qualité des données collectées ?

- Qui est responsable de la supervision du système où se trouvent les données ?

- Qui peut influencer les changements ou les améliorations de ces systèmes ?

- Qui peut aider à évaluer si les mesures d’amélioration prévues ont un sens, une utilité et une pertinence pour les parties prenantes et les propriétaires de systèmes ?

3 – L’importance de la découverte des problèmes et des opportunités liés à la gestion et à l’utilisation des donnée.

Toute initiative d’amélioration commence par une phase de diagnostic pour comprendre la nature, l’ampleur et l’impact des problèmes de qualité. Cette première étape se déroule en deux temps.

Comprendre les enjeux métier. Il est crucial de lier les problèmes de données aux objectifs de l’entreprise. Avant de plonger dans l’analyse technique, il faut dialoguer avec les parties prenantes stratégiques pour comprendre leurs défis. Un problème de qualité des données n’a d’importance que s’il entrave un processus critique ou une décision importante.

Identifier et hiérarchiser les problèmes à résoudre. La compréhension des dysfonctionnements ou des manques réels passe par des entretiens avec les producteurs et les consommateurs de données sur le terrain. À partir d’exemples vécus, ces discussions permettent de relier les problèmes et les opportunités manquées aux défis stratégiques. La hiérarchisation des problèmes est guidée par l’alignement sur la stratégie de l’entreprise et ses objectifs métier. Autrement dit, le périmètre de la stratégie doit être défini en fonction des priorités déterminées par le niveau d’impact de chaque problème sur la réalisation des objectifs métier. De cette manière, on cherche à concentrer les efforts sur les problèmes dont la résolution est considérée comme non négociable. Plusieurs types de bénéfices sont à considérer : le gain financier, la réduction des risques (opérationnels, réputationnels, de conformité), l’amélioration des processus décisionnels grâce à une confiance accrue dans les données, l’obtention d’un avantage…

4 – L’importance de l’identification des données et des causes à l’origine des problèmes.

Il est essentiel de savoir sur quoi agir, où intervenir et avec qui collaborer. Les problèmes identifiés, qui orientent la définition et la mise en œuvre de la stratégie, sont reliés aux données, aux applications impliquées dans leur cycle de vie, ainsi qu’aux acteurs qui produisent ou consomment ces données. À ce stade, il est recommandé d’examiner les caractéristiques des données qui peuvent, seules ou conjointement, être à l’origine des problèmes ciblés par le plan d’amélioration. Ces caractéristiques s’organisent généralement autour de quatre axes principaux.

- L’utilité, qui évalue si les données sont pertinentes et adaptées aux besoins des utilisateurs.

- L’accessibilité, qui examine la disponibilité des systèmes et des transactions pour les utilisateurs autorisés.

- La crédibilité, qui valide la fiabilité et la véracité des données à travers leur exactitude et leur cohérence.

- L’interprétabilité, qui garantit que les données peuvent être correctement comprises, en tenant compte de leur syntaxe, de leur sémantique et de la traçabilité de leur origine.

5 – L’importance de définir et mettre en œuvre, en priorité, des actions de prévention.

Il est nécessaire de privilégier l’approche proactive comme fondation pour garantir une qualité durable et rentable. Cette approche se concentre sur l’anticipation des problèmes et l’optimisation des processus avant que des défaillances ne se manifestent. Le principal argument en faveur de la prévention se fonde sur la règle 1-10-100. Cette règle établit que la prévention coûte moins cher que la remédiation et qu’être proactif est préférable à être réactif. En clair, corriger une erreur immédiatement à la source (par exemple lors de la saisie d’une donnée) coûte très peu (1). Si l’erreur est détectée plus tard, dans un rapport ou lors d’un contrôle intermédiaire, son coût est environ 10 fois supérieur. Si l’erreur n’est jamais corrigée et qu’elle affecte directement les opérations, les clients où la réputation, le coût peut être 100 fois plus élevé.

L’objectif est de passer d’une organisation qui réagit aux défaillances aiguës des données à une organisation qui contrôle et limite de manière proactive l’introduction des défauts de données dans le SI.

6 – L’importance de corriger seulement là où le ROI existe.

L’objectif n’est jamais d’atteindre une qualité absolue de 100 % sur l’ensemble des données concernées par des défauts de qualité. C’est en même temps irréaliste et la plupart du temps extrêmement coûteux. Il s’agit plutôt de concentrer les efforts là où l’impact économique et/ou métier est le plus fort. Les actions de remédiation doivent être définies en fonction de la valeur que les données génèrent pour le métier. Par exemple, un indicateur de qualité brute faisant état d’un taux de non-conformité de 7,45 %, mais une analyse montrant que ces erreurs ne concernent en réalité que 0,05 % du chiffre d’affaires et qu’il suffirait de corriger moins de 1 % des erreurs initiales pour éliminer 100 % du risque financier identifié.

L’alignement systématique des efforts de qualité des données sur la valeur métier opère un changement de paradigme fondamental. Ce changement de perspective permet de réduire considérablement l’effort de correction tout en maximisant l’impact métier.

Ne subissez plus la non-qualité, transformez vos données en levier stratégique

La qualité des données n’est ni un état figé ni un objectif abstrait. Elle se pilote, se priorise et s’entretient dans la durée, au croisement des enjeux métier, des processus et des responsabilités. En identifiant clairement les risques, les usages critiques et les points de création de valeur, l’organisation se donne les moyens de sortir d’une logique défensive pour entrer dans une maîtrise offensive de son actif informationnel.

Ce changement de posture est décisif : il permet de concentrer les efforts là où le ROI est réel, de prévenir les défauts plutôt que de les subir, et de faire des données un socle fiable pour décider, innover et se différencier durablement.

Menu

Menu